En Vedette

Nouvelles générales

Une prouesse remarquable

Des textes qui génèrent des images.

juillet 10, 2022

par Pierre Deschamps

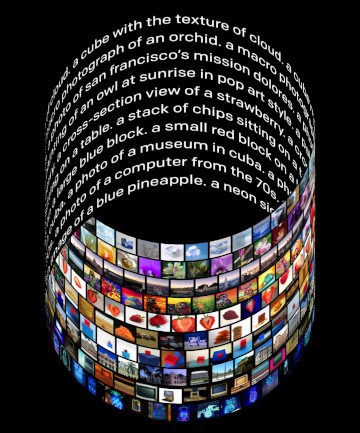

(Photo credit: OpenAI)

(Photo credit: OpenAI) Aux confins de l’univers numérique naissent des aventures qui, il y a quelques années encore, n’étaient que chimères. Ainsi en est-il des logiciels qui peuvent convertir des mots en images. Déjà de nombreuses équipes sont à pied d’œuvre pour produire des outils dont l’utilisation donne un tout autre sens au dicton qui dit qu’une image vaut mille mots.

Au départ, il y a OpenAI, une jeune entreprise de San Francisco spécialisée en intelligence artificielle à qui l’on doit déjà GPT-3, un outil puissant pour générer des passages de textes sophistiqués à partir d’instructions assez simples, et Copilot, un outil qui aide à automatiser l’écriture de code pour les ingénieurs en logiciel.

Puis voilà qu’en janvier 2021 OpenAI crée l’événement avec la première version de DALL-E, un outil capable de générer des images de 256 pixels sur 256. En poursuivant ses recherches, elle a rapidement édité une deuxième version qui peut produire des images de 1 024 pixels sur 1 024.

Sommairement, ce logiciel innovateur peut créer des images et des œuvres d’art originales et réalistes à partir d’un simple descriptif textuel. Il peut combiner des concepts, des attributs et des styles.

Comme l’explique OpenAI : « DALL·E 2 peut apporter des modifications réalistes aux images existantes à partir d’une légende en langage naturel. Il peut ajouter et supprimer des éléments tout en tenant compte des ombres, des reflets et des textures. » Le logiciel peut également « prendre une image et créer différentes variations inspirées de l’original ».

En fait, DALL·E 2 établit une relation entre les images et le texte utilisé pour les décrire. Il utilise un processus appelé « diffusion », qui commence par un motif de points aléatoires et modifie progressivement ce motif vers une image lorsqu’il reconnaît des aspects spécifiques de cette image.

Plus précisément, « considérez l’expression “un hérisson portant un chapeau rouge, des gants jaunes, une chemise bleue et un pantalon vert”. Pour interpréter correctement cette phrase, DALL E 2 doit non seulement composer correctement chaque vêtement avec l’animal, mais aussi former les associations (chapeau, rouge), (gants, jaune), (chemise, bleu) et (pantalon, vert) sans les mélanger ».

Cela dit, OpenAI « a limité la capacité de DALL·E 2 à générer des images violentes, haineuses ou pour adultes. En supprimant le contenu le plus explicite des données de formation, nous avons minimisé l’exposition de DALL·E 2 à ces concepts. Nous avons également utilisé des techniques avancées pour empêcher les générations photoréalistes de visages réels d’individus, y compris ceux de personnalités publiques ».

Dans la foulée de cette position éthique, la société californienne a décidé de travailler avec des experts externes et de prévisualiser « DALL·E 2 à un nombre limité d’utilisateurs de confiance qui nous aideront à en savoir plus sur les capacités et les limites de la technologie. Nous prévoyons d’inviter davantage de personnes à prévisualiser cette recherche au fil du temps, à mesure que nous apprenons et améliorons de manière itérative notre système de sécurité ».

Comme très souvent, d’autres innovateurs se sont eux aussi lancés dans la mise au point d’outils de création d’images à partir de textes descriptifs. Ainsi en est-il de Imagen, un modèle de diffusion texte-image avec un degré élevé de photoréalisme et un niveau profond de compréhension du langage mis au point par une équipe de chercheurs de Google Research spécialisés en vision par ordinateur et en reconnaissance de formes.

Au dire de l’équipe : « Notre découverte clé est que les grands modèles de langage génériques (par exemple T5), pré-entraînés sur des corpus textuels uniquement, sont étonnamment efficaces pour encoder du texte pour la synthèse d’images : l’augmentation de la taille du modèle de langage dans Imagen améliore à la fois la fidélité de l’échantillon et l’alignement image-texte ».

À cette fin, ces chercheurs ont mis au point « DrawBench, une référence complète et stimulante pour les modèles texte-image. Avec DrawBench, nous comparons Imagen avec des méthodes récentes telles que VQ-GAN + CLIP, les modèles de diffusion latente et DALL-E 2, et constatons que les évaluateurs humains préfèrent Imagen aux autres modèles dans des comparaisons côte à côte, à la fois en termes de qualité d’échantillon et d’alignement image-texte. »

Par ailleurs, il n’est pas vain de noter la diffusion récente de LAION-5B, un ensemble de données d’entraînement à l’IA contenant plus de cinq milliards de paires image-texte publié sur le blog LAION (Large-scale Artificial Intelligence Open Network).

Cet ensemble de données, qui est 14 fois plus volumineux que son prédécesseur LAION-400M, contient des images et des légendes collectées sur Internet, ce qui en fait l’ensemble de données image-texte le plus important disponible en libre accès. L’ensemble de données contient 2,32 milliards de photos avec du texte en anglais, 2,26 milliards d’images avec du texte dans d’autres langues et 1,27 milliard d’images avec un langage textuel non ambigu.

https://openai.com/

https://imagen.research.google/

https://research.google/

https://laion.ai/

Print this page